Qu’est-ce qu’un capteur d’images ?

À quoi sert-il ?

Un capteur d’image est un composant électronique qui a pour but de capturer et de numériser des images.

Comment fonctionne-t-il ?

Pour comprendre le fonctionnement d’un capteur d’images, il faut d’abord comprendre deux choses :

1. La lumière est composée de photons, c’est-à-dire de petites particules d’énergie créées par une source lumineuse (soleil, ampoule, etc.).

2. Il est possible de « convertir » les photons en électrons, c’est ce qu’on appelle l’effet photoélectrique. En physique, l’effet photoélectrique (EPE) désigne l’émission d’électrons par une matière, généralement métallique, lorsqu’elle est exposée à la lumière ou à un rayonnement électromagnétique de fréquence suffisamment élevée, selon la matière.

Plus précisément, un capteur d’images transforme l’énergie lumineuse en énergie électrique. Il est composé de cellules photosensibles, appelées photodiodes.

Si un photon contenant suffisamment d’énergie « frappe » la photocathode, il va libérer un électron qui va générer un signal électrique analogique. Le convertisseur analogique/numérique permettra ensuite de numériser cette information.

Ces photocathodes sont disposées sur la surface du capteur de manière à former une matrice de pixels. Cette matrice nous donne la définition du capteur (par exemple un capteur HD comprend 1920 pixels de large x 1080 pixels de haut).

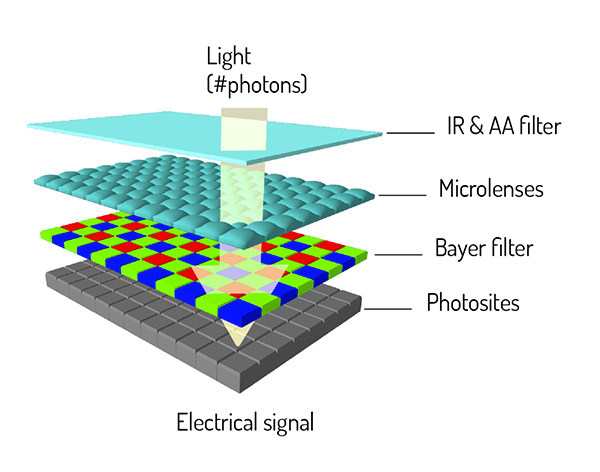

En outre, le capteur est équipé d’un filtre (souvent infrarouge), de microlentilles (qui permettent de canaliser la lumière vers les photosites) et d’un filtre de Bayer (qui lui permet de récupérer la couleur au niveau du pixel).

Quelles sont les caractéristiques d’un capteur d’images ?

> Bande de fréquence : UV / Visible / Nuit / VNIR / NIR / SWIR / MWIR / THERMIQUE LWIR / THz

> Technologie de fabrication : CCD / CMOS / EBCMOS

> Dimensions physiques : longueur x largeur

> Résolution : taille de l’image en pixels (largeur x hauteur) et taille des pixels

> Sensibilité : capacité à capturer des images de haute qualité en fonction de la luminosité

> fps * : frame / second = nombre d’images par seconde que le capteur est capable de capturer

> Type : Rolling Shutter / Global shutter, c’est-à-dire la manière d’exposer les cellules photosensibles [rolling shutter : affichage des lignes une par une > espaces entre les lignes / économise la sortie du transistor et la capacité pour chaque pixel, donc beaucoup moins cher (plus facile à fabriquer) / global shutter : tout s’affiche au moment où il est lu].

*fps (frames / second) : kézako ?

Une vidéo est en fait une succession d’images fixes. En les mettant bout à bout, on finit par voir une scène en mouvement.

Il faut environ 25 images par seconde pour que l’homme voie une vidéo de manière assez fluide. En deçà, la vidéo est perçue comme saccadée. Aller au-delà de 25 images par seconde peut s’avérer très utile pour les ralentis. Vous vous souvenez de ces publicités où l’on voit une goutte d’eau qui tombe doucement, puis une multitude de mini gouttes qui s’amusent ? Cela est possible grâce à la capture de nombreuses images dans un laps de temps très court.

En d’autres termes, si vous devez capturer une scène dans laquelle les objets se déplacent très rapidement (ex : Formule 1) et que vous voulez voir, par exemple, exactement quelles sont les deux voitures qui franchissent la ligne d’arrivée en premier (au cas où elles passeraient la ligne en même temps), un capteur d’image capable de capturer un très grand nombre d’images par seconde (par exemple, 60 à 100 images par seconde) devra être utilisé afin de pouvoir faire défiler les images image par image pour obtenir un résultat précis.

Une fois la lumière transformée en énergie électrique, il est nécessaire de pouvoir :

Ensuite, pouvoir soit :

Reconstituer les images au plus près de la réalité (quelles que soient les conditions environnementales).

Dans la partie bleue du tableau ci-contre, on trouve toute une série d’algorithmes permettant de recréer des images à partir des données capturées par le capteur d’images.

Pour ce faire, des opérations très complexes doivent être réalisées en temps réel, afin de traiter :

les informations brutes des capteurs

les corrections et améliorations des performances de l’optique et du système (aberrations, distorsion, stabilisation, etc.)

les corrections de prétraitement (exposition automatique, correction des pixels morts, etc.)

Améliorations telles que HDR, amélioration du contraste, correction des vibrations, etc.

Extraire des informations de la situation observée afin de décider et de lancer différentes mesures.

Dans la partie jaune du tableau ci-contre, on peut voir différents algorithmes qui peuvent analyser les pixels d’une image pour en extraire des informations.

Il peut s’agir d’algorithmes

Comme vous pouvez le constater, un système de vision n’est pas un simple caméscope qui sert uniquement à filmer des vacances, mais un système puissant composé non seulement d’un système de capture d’images dans différentes bandes de fréquences, mais aussi d’une intelligence (analytique) dont les applications sont vastes et applicables dans de nombreux domaines. Il permet également d’augmenter les capacités humaines en ayant la possibilité de voir ce que nous ne pouvons normalement pas voir, tout en traitant à une fréquence très élevée, ce que nous ne pouvons pas non plus faire.